개요

머신러닝 강의 2주차 내용을 정리합니다

본문

이제 gradient descent 가 더욱 잘 동작할 수 있게 하는 몇가지 기술들을 알아본다.

이번에는 Feature scailing 이라는 gradient descent를 더욱 빠르게 동작시키게 하는 기술에 대해서 다뤄볼 것이다.

먼저 feature (x) 의 값과 연관된 parameter (w) 값 간의 관계를 살펴보자.

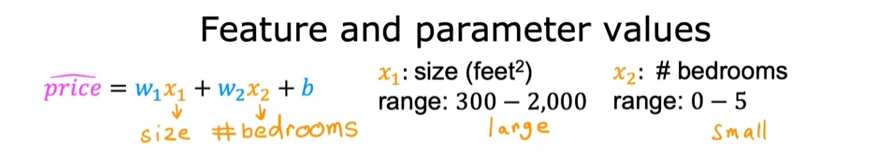

첫 예제로, 두 개의 feature을 사용해 집값을 예측하는 것을 보도록 하자. x1 은 집 크기이고, x2는 침실의 갯수이다.

그리고 각 feature들의 값 범위는 아래와 같다. 상대적으로 x1의 범위가 x2의 범위보다 더 크다.

이제 한 학습 예제를 살펴보면, x1 은 2000, x2 는 5, 집가격은 500K달러다. 이 경우 w1과 w2를 어떻게 설정해야 적절할까?

위 학습 예제의 가격을 예측하기 위한 x 값에 대한 선정을 아래와 같이 하였다.

첫번 째 경우 결과값이 너무 커서 500K 달러를 훨씬 상회하였고 두번 째 경우 딱 맞아떨어졌다.

여기서 알아야 할 것은 x1처럼 feature 값의 범위가 클때, 좋은 모델은 0.1 과 같이 상대적으로 작은 매개변수 값을 선택하는 방법을 배울 가능성이 더 높다는 것이다.

출처

'머신러닝 > Coursera 강의 정리' 카테고리의 다른 글

| 2주차 강의 내용 정리 - 1 (0) | 2023.07.19 |

|---|---|

| 1주차 강의 내용 정리 - 7 (0) | 2023.07.18 |

| 1주차 강의 내용 정리 - 6 (0) | 2023.07.12 |

| 1주차 강의 내용 정리 - 5 (0) | 2023.07.06 |

| 1주차 도입부 - What is machine learning? (0) | 2023.06.18 |

댓글